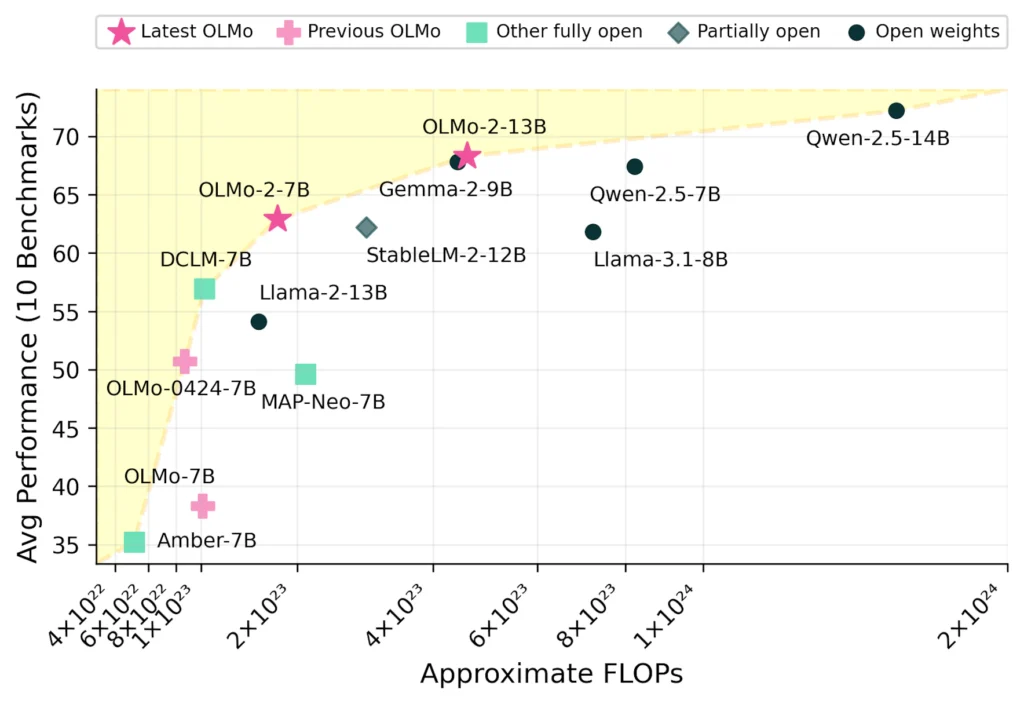

Ai2, yapay zekanın daha erişilebilir hale gelmesi ve açık kaynak ile özel çözümler arasındaki farkı azaltma hedefiyle OLMo 2 adlı açık kaynaklı dil modeli ailesini tanıttı. Bu yeni model serisi, 7B ve 13B parametre sürümleriyle sunuluyor ve toplamda 5 trilyona kadar token üzerinde eğitim almış durumda. OLMo 2, açık kaynaklı modellerle kıyaslandığında benzer veya hatta daha iyi performans gösterebilen bir seçenek olarak dikkat çekiyor. Ayrıca, İngilizce akademik standartlarda Llama 3.1 gibi önde gelen açık kaynak modelleriyle rekabet edebilecek düzeyde bir başarı sergiliyor.

Ai2’nin ilk OLMo modelini Şubat 2024‘te piyasaya sürdüğünü hatırlatan açıklamalarda, açık dil modeli ekosisteminde hızlı bir gelişim ve açık ile özel modeller arasındaki performans farkının giderek daraldığı vurgulandı.

OLMo 2’deki Yenilikçi Teknik İyileştirmeler

OLMo 2’nin başarılı bir şekilde geliştirilmesinde birkaç önemli teknik yenilik etkili oldu. Modelin eğitim kararlılığını artırmak ve daha verimli sonuçlar elde etmek için çeşitli yöntemler kullanıldı. Bu yenilikler arasında, parametrik olmayan katman normu yerine RMSNorm‘a geçiş ve rotary pozisyonel gömme (rotary positional embedding) gibi gelişmeler bulunuyor.

Ayrıca, OLMo 2’nin eğitim sürecinde kullanılan Tülu 3 çerçevesinden türetilen en son eğitim sonrası metodolojiler de modelin başarısına katkıda bulundu. Bu teknik iyileştirmeler, OLMo 2’nin açık kaynak dünyasında güçlü bir rakip haline gelmesini sağladı.

OLMo 2 Eğitim Süreci: Çığır Açan Yaklaşım

OLMo 2’nin eğitimi, oldukça sofistike ve iki aşamalı bir süreçle gerçekleştirildi:

- İlk Aşama: Bu aşamada OLMo-Mix-1124 veri kümesi kullanıldı. Bu küme, DCLM, Dolma, Starcoder ve Proof Pile II gibi kaynaklardan oluşturuldu ve toplamda yaklaşık 3,9 trilyon token içeriyor.

- İkinci Aşama: Yüksek kaliteli web verileri ve belirli alanlara özgü içeriklerden seçilmiş veri karışımı içeren Dolmino-Mix-1124 veri kümesi ile eğitim tamamlandı. Bu aşama, modelin daha geniş ve daha özelleşmiş içeriklerle eğitim almasını sağladı.

OLMo 2-Instruct-13B: Serinin En Güçlü Modeli

OLMo 2-Instruct-13B, OLMo 2 serisinin en güçlü ve yetenekli modeli olarak öne çıkıyor. Bu model, çok çeşitli görevlerde olağanüstü başarılar elde etti. Özellikle, Qwen 2.5 14B Instruct, Tülu 3 8B ve Llama 3.1 8B Instructmodelleriyle karşılaştırıldığında üstün sonuçlar gösterdi.

OLMo 2-Instruct-13B’nin bu başarıları, açık kaynaklı yapay zeka dünyasında ve genel olarak yapay zeka alanında önemli bir etki yaratma potansiyeline sahip olduğunu gösteriyor. Modelin güçlü performansı, gelecekte daha fazla araştırma ve uygulama için temel teşkil edecek.

Ai2’nin Açık Bilime Olan Bağlılığı

Ai2, açık bilime olan bağlılığını daha da güçlendirerek, modelin ağırlıkları, verileri, kodları, tarifleri ve ara kontrol noktalarını içeren kapsamlı bir dokümantasyon yayınladı. Bu sayede, araştırmacılar ve geliştiriciler OLMo 2’nin iç işleyişini tamamen inceleyebilir, sonuçları yeniden üretebilir ve daha ileriye taşıyabilir.

Ayrıca, Ai2, OLMES (Open Language Modeling Evaluation System) adını verdiği yeni bir değerlendirme çerçevesi tanıttı. OLMES, bilgi hatırlama, sağduyu akıl yürütme ve matematiksel akıl yürütme gibi temel yetenekleri değerlendiren 20 ölçüt sunuyor. Bu çerçeve, OLMo 2’nin yeteneklerini daha derinlemesine anlamayı ve geliştirmeyi amaçlıyor.

OLMo 2’nin Potansiyeli: Açık Kaynaklı Dil Modellerinde Devrim

Ai2’nin OLMo 2 serisi, açık kaynaklı dil modelleri konusunda önemli bir dönüm noktası oluşturuyor. Geliştirdiği yeni teknikler, eğitim süreçleri ve güçlü performansıyla OLMo 2, açık bilimin gücünü yapay zeka dünyasına entegre ediyor. Modelin şeffaflık politikası, araştırma topluluğunun daha hızlı ve etkili şekilde yenilikler yapmasını mümkün kılacak. Ai2’nin bu adımı, yapay zekanın daha demokratik ve erişilebilir hale gelmesi için kritik bir rol oynayacak.OLMo 2, açık kaynak yapay zeka geliştirme alanında standartları yükseltiyor. Bu yaklaşım, şeffaflık ve erişilebilirliği korurken yenilik hızını artırma potansiyeline sahip.